Paweł Olędzki / 10 maja 2024

Dataflow - co to jest?

W dobie dynamicznego rozwoju technologii i rosnącej ilości danych, efektywne zarządzanie przepływem informacji w firmach stało się kluczowe dla osiągania sukcesów biznesowych. Jednym z fundamentalnych pojęć w dziedzinie analizy danych i business intelligence jest dataflow. Czym dokładnie jest dataflow i jak wpływa na funkcjonowanie firm? Przyjrzyjmy się temu bliżej.

Definicja Dataflow

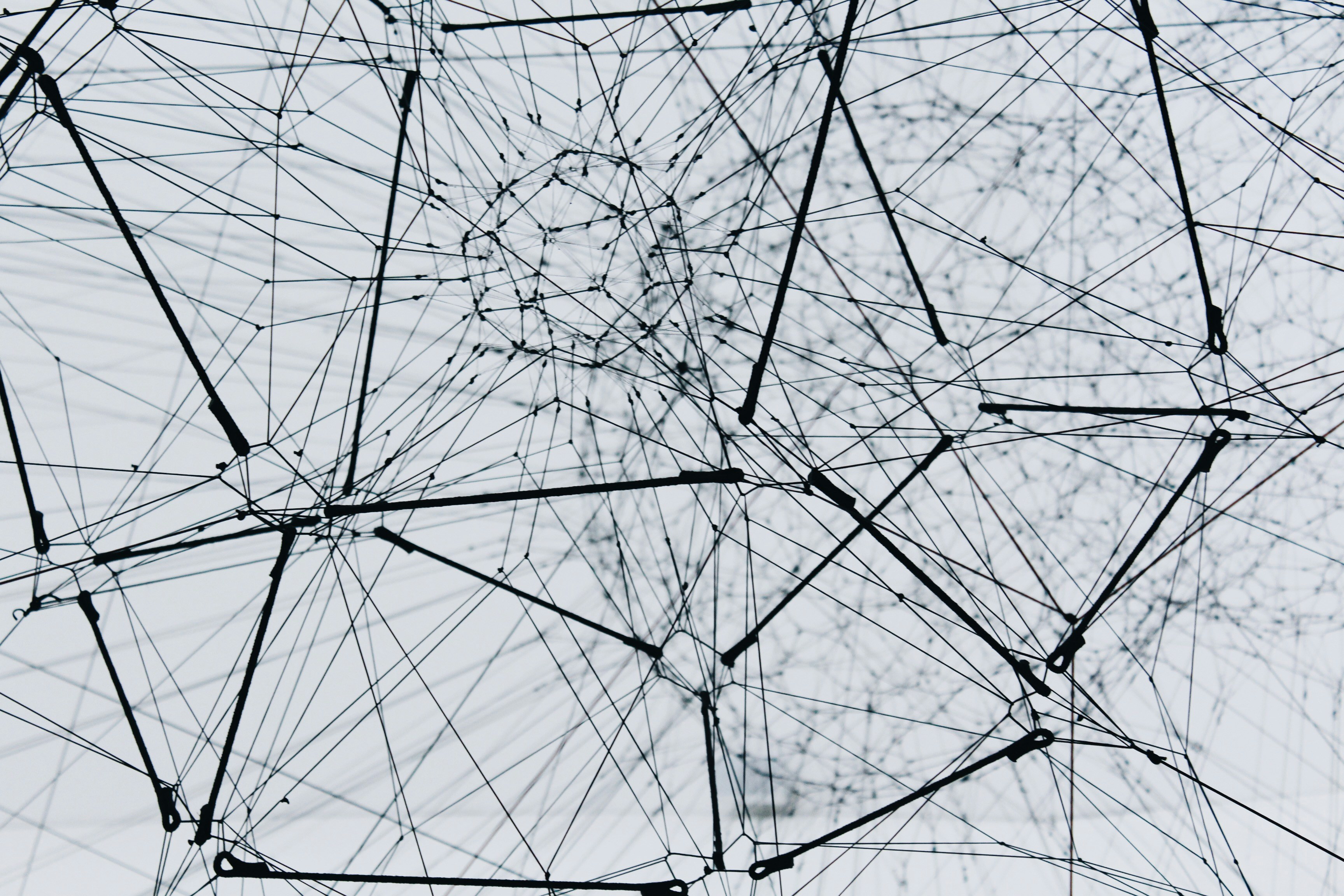

Dataflow, czyli przepływ danych, odnosi się do sposobu, w jaki dane są przetwarzane i przesyłane w systemach informatycznych. Jest to model przetwarzania, w którym dane przepływają przez różne etapy przetwarzania (nazywane często "węzłami" lub "operators"), zanim dotrą do końcowego punktu. Każdy etap może wykonywać określone operacje, takie jak filtrowanie, transformowanie, agregowanie czy wzbogacanie danych.

W kontekście technicznym, dataflow można porównać do schematu blokowego, gdzie dane przepływają przez różne bloki, z których każdy wykonuje specyficzne operacje. Taki model pozwala na wyraźne zobrazowanie, jak dane są przetwarzane i jak różne etapy przetwarzania są ze sobą powiązane.

Znaczenie Dataflow w Analityce Danych

W kontekście analityki danych, dataflow jest kluczowym elementem umożliwiającym:

- Automatyzację Procesów Analitycznych: Dzięki dataflow możliwe jest automatyczne przetwarzanie dużych zbiorów danych bez konieczności ręcznej interwencji na każdym etapie. Automatyzacja pozwala na ciągły i nieprzerwany przepływ danych, co jest niezbędne w dzisiejszym dynamicznym środowisku biznesowym.

- Integrację Danych z Różnych Źródeł: Firmy często posiadają dane pochodzące z różnych systemów – CRM, ERP, narzędzi marketingowych i wielu innych. Dataflow pozwala na integrację tych danych w jednolitym procesie przetwarzania. Dzięki temu można uzyskać pełniejszy obraz działalności firmy, co jest kluczowe dla podejmowania trafnych decyzji biznesowych.

- Zwiększenie Efektywności: Automatyzacja i integracja danych prowadzą do znacznego skrócenia czasu potrzebnego na uzyskanie wartościowych informacji, co z kolei zwiększa efektywność operacyjną firm. Szybsze przetwarzanie danych oznacza szybszy dostęp do informacji, co pozwala na szybsze reagowanie na zmiany na rynku.

- Poprawę Jakości Danych: Poprzez zastosowanie różnych mechanizmów kontroli i czyszczenia danych w ramach dataflow, firmy mogą znacząco poprawić jakość swoich danych. Lepsza jakość danych przekłada się na bardziej wiarygodne analizy i raporty, co jest kluczowe dla podejmowania strategicznych decyzji.

Przykłady Zastosowań Dataflow

Dataflow znajduje zastosowanie w wielu dziedzinach i scenariuszach biznesowych, takich jak:

- ETL (Extract, Transform, Load): Proces ETL jest jednym z najczęstszych przykładów wykorzystania dataflow. Polega on na ekstrakcji danych z różnych źródeł, ich transformacji w odpowiedni format i załadowaniu do docelowego systemu, na przykład hurtowni danych. ETL jest niezbędny do konsolidacji danych z różnych systemów w jedną, spójną bazę danych.

- Stream Processing: W przypadku danych strumieniowych, które są generowane w czasie rzeczywistym (np. dane z czujników IoT, logi serwerów), dataflow pozwala na ich natychmiastowe przetwarzanie i analizę. Przetwarzanie strumieniowe jest kluczowe w scenariuszach, gdzie czas reakcji jest krytyczny, na przykład w monitoringu systemów lub analityce finansowej.

- Machine Learning Pipelines: W modelach uczenia maszynowego dataflow jest używane do przygotowania danych, trenowania modeli oraz monitorowania wyników predykcji. Dataflow umożliwia automatyzację całego procesu, od wstępnej obróbki danych po wdrożenie modelu produkcyjnego.

Narzędzia wspierające Dataflow

Na rynku dostępnych jest wiele narzędzi wspierających koncepcję dataflow. Wśród nich można wymienić:

- Apache NiFi: Narzędzie open-source umożliwiające automatyzację przepływów danych między różnymi systemami. Apache NiFi oferuje łatwy w użyciu interfejs graficzny, który pozwala na projektowanie złożonych przepływów danych bez konieczności pisania kodu.

- Google Cloud Dataflow: Usługa w chmurze Google, która oferuje przetwarzanie danych w trybie strumieniowym i wsadowym. Google Cloud Dataflow opiera się na modelu Apache Beam i jest idealnym rozwiązaniem dla firm, które potrzebują skalowalnego i elastycznego narzędzia do przetwarzania dużych zbiorów danych.

- Apache Beam: Model programowania do definiowania przetwarzania dataflow, który może być uruchamiany na różnych silnikach przetwarzania danych, takich jak Google Cloud Dataflow czy Apache Flink. Apache Beam pozwala na tworzenie przenośnych przepływów danych, które mogą być uruchamiane w różnych środowiskach.

Przykładowy scenariusz zastosowania Dataflow w firmie

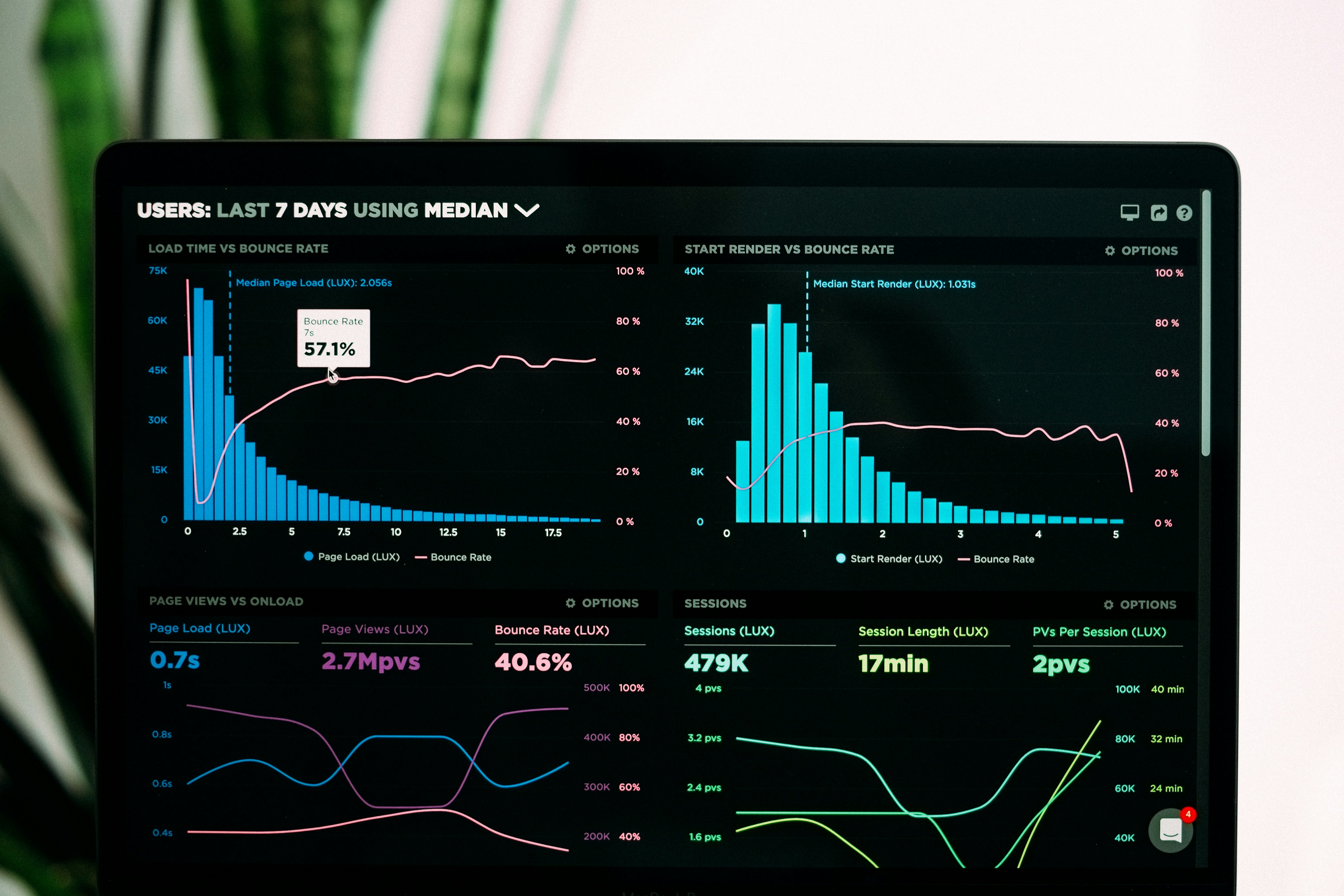

Wyobraźmy sobie firmę e-commerce, która gromadzi dane z różnych źródeł, takich jak strona internetowa, system CRM, media społecznościowe i logi serwerów. Dzięki zastosowaniu dataflow, firma może:

- Zintegrować dane z różnych źródeł: Dane z różnych systemów są zbierane i łączone w jednym procesie przetwarzania, co pozwala na uzyskanie pełnego obrazu zachowań klientów.

- Przetworzyć dane w czasie rzeczywistym: Dzięki przetwarzaniu strumieniowemu, firma może natychmiast reagować na zmiany w zachowaniach klientów, na przykład poprzez dostosowanie ofert marketingowych w czasie rzeczywistym.

- Poprawić jakość danych: W ramach dataflow można zaimplementować mechanizmy czyszczenia i walidacji danych, co zapewnia, że dane używane do analiz są wysokiej jakości.

- Automatyzować raportowanie: Automatyzacja przepływów danych pozwala na regularne generowanie raportów bez konieczności ręcznej interwencji, co oszczędza czas i zmniejsza ryzyko błędów.

Podsumowanie

Dataflow jest nieodzownym elementem nowoczesnych systemów analizy danych i business intelligence. Umożliwia firmom efektywne zarządzanie i przetwarzanie dużych ilości danych, co prowadzi do lepszych decyzji biznesowych i większej konkurencyjności na rynku. Wdrożenie systemów opartych na dataflow może znacząco usprawnić procesy analityczne, poprawić jakość danych oraz zwiększyć efektywność operacyjną firmy. Warto więc zainwestować w odpowiednie narzędzia i technologie, które pozwolą w pełni wykorzystać potencjał dataflow w organizacji.

Dataflow to nie tylko technologia, ale także filozofia zarządzania danymi, która kładzie nacisk na automatyzację, integrację i ciągłość przetwarzania danych. Dzięki odpowiedniemu podejściu do dataflow, firmy mogą uzyskać przewagę konkurencyjną i skuteczniej realizować swoje cele biznesowe.